做网站优化我们要规避哪些蜘蛛陷阱?

做网站优化,重点往往不是”我们觉得”而是“搜索引擎觉得”,所以除了要产出大量优质内容外,还要清除不利于搜索引擎理解我们网站的障碍,比如蜘蛛陷阱:flash、图片、js调用、session ID.各种跳转、frame框架、必须登录、导航栏js、必须使用cookies等。下面就由我们一起看一下具体情况和解决方案。

蜘蛛陷阱介绍

1、JS脚本

JS在网站建设中有着举足轻重的作用,因为它能为网站实现很多酷炫的效果,但是依旧摆脱不了不利于蜘蛛爬取的问题,而且网站有太多的JS还会影响严重影响网站的加载速度。

解决办法:对于某些排名毫无意义的页面,用JS脚本阻止蜘蛛对它的抓取,由于集中权重

2、Flash模块

Flash模块确实给人的视觉效果非常棒的体验,但蜘蛛难以识别flash内容,所以过多的flash会影响,搜索引擎对网站相关性的判断。

解决办法:视频网站用FLASH格式可以达到占用资源小 效益最大化的目的。

3、frame框架结构

落后就要挨打,在现在的智能时代,框架结构逐渐落伍并且非常不利于蜘蛛爬取网站的内容。

解决办法:用DIV+css或者Ajax代替frame吧

4、Session ID

网站采用Session ID做用户跟踪访问,会导致蜘蛛访问这种网站的时候,即使访问的是同一个页面,也会出现不一样的ID,根本就很难判断出哪个url才是主要页面,甚至还会误判为网站有大量页面存在重复的内容,导致网站降权。

解决办法:技术处理,把session id保存在persistent cookie中(通过设置session的最大有效时间),然后在新窗口读出上一个窗口的session id。

5、带各种参数的动态URL

网站动态的URL越多,网站越会误导搜索引擎,如果设置不当也会造成搜索引擎判断不清到底哪个是正规的页面(原理上跟SessionID相似),而且动态URL也是不利于蜘蛛抓取的,我们应该避免,建议站长手上的网站都要做一下静态化,并且屏蔽掉那些异常参数的url。

解决办法:做好网站URL规范化处理,避免动态参数过多。

6、登录限制或强制使用cookie

有登录限制的内容,对于搜索引擎来说它即不会注册也不会登录,这样的内容蜘蛛是发现不了的;同样强制使用Cookies只能造成搜索引擎蜘蛛无法正常访问。

建议:详情页

7、异常跳转

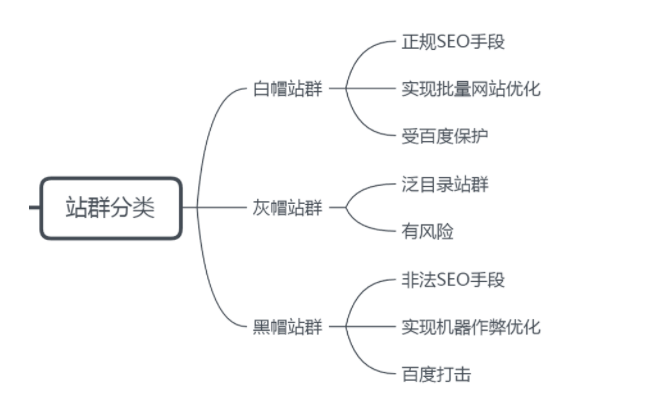

杂七杂八的跳转,常用于一般灰帽或黑帽,做采用变相引流。常见的例如:JS跳转、Flash跳转、302跳转等。而至于301跳转是受搜索引擎推荐和认可的,所以不包括在列。

解决办法:白帽seo尽量少用,否则会被当做作弊手段。

最后,有些网站为了跟用户交流就时不时的强出很多聊天窗口,这些往往会降低用户体验,而且这些聊天窗口搜索引擎也无法识别的,所以尽量不用。

网站SEO优化的9大蜘蛛陷阱

我们从事网站优化的过程中,尤其是现在收入对于网站而言是非常重要的网站,只有有了比较不错的收录之后,才有可能会取得不错的排名,因此在网站设计的时候,我们就要尽可能的让蜘蛛能够获取到网站的全部内容信息,如果说在网站的程序上,或者说是设计上出现了蜘蛛陷阱,就会导致蜘蛛无法获取站点的内容。

有些朋友为了网站好看、炫酷等等,但是却导致了蜘蛛抓取困难,这在一定程度上就形式了蜘蛛陷阱,那么具体有哪些情况会出现这种蜘蛛陷阱呢?

一、JS

有些朋友为了让网站吸引用户的眼球,就把导航、网站的首页界面等等都使用了大量的JS脚本,这对于蜘蛛抓取也是不利的。对于这一点可能存在一定的争议,问题在于到底要不要把它划到蜘蛛陷阱这一块。

JS在网站建设中有着举足轻重的作用,因为它能为网站实现很多酷炫的效果,但是它依旧摆脱不了不利于蜘蛛爬取的问题,就这一点来说它可以算是蜘蛛陷阱,但是它也可以用在网站的其他方面对咱们做SEO的还是有所帮助的,比如为了避免网站权重的分散,不想让一些对网站排名毫无意义的页面被收录,我们就可以用JS脚本阻止蜘蛛对该页面的抓取,而就这一点来说它又是我们做网站优化的好帮手,所以对于JS脚本这一点还是全凭自己且用且拿捏吧!

二、框架结构

框架结构里面的html通常情况下是可以被蜘蛛抓取的,但是一般情况下这里面的内容不是完整的,导致的结果就是搜索引擎无法判断框架里面的内容到底是主框架还是框架调用的文件。

框架结构就目前来说算的上是网站建设界的老古董了,业界在刚开始建设网站的时候会用框架结构来设计相关的页面,在当时来讲的确提供了不少方便,但在现如今建站愈来愈简单智能的时代,框架结构逐渐落伍并且非常不利于蜘蛛爬取网站的内容,所以框架结构是被逼成了蜘蛛陷阱,老实讲这不能怪它,可是也不得不怪它,这同时也验证了一句话:落后就要挨打。

三、有过多的flash

不得不说Flash能为我们的网站增色不少,恰到好处的Flash能够让我们的网站看起来高端大气上档次,但是不要因为它有这些优点我们就可以滥用,不管什么地方都去整个Flash什么的,那样只会适得其反,之所以这么说是由于搜索引擎对Flash的抓取很不理想,偶尔用到几乎没什么影响,但是如果你的整个首页就只用了一个超大的Flash亦或是页面上面到处都是Flash,这就变成了蜘蛛陷阱。虽然搜索引擎一直在竭尽全力攻克这方面抓取的难题,但到目前为止效果还是不怎么好,所以我们也只能主动避开这些问题。

目前的flash也是蜘蛛难以识别的,这对于搜索引擎来说也是一种看不懂的东西,那么及时再好的视觉效果,也会让搜索引擎无法判断对应的相关性。

四、Session ID

Session ID用户跟踪访问,造成的现象就是用户每访问一个页面,就会出现不一样的Session ID,也就是说访问同样的页面,但是出现不一样的ID,这就造成了大量重复性的内容,也不利搜索引擎优化的。

五、异常跳转

网站的跳转方法多种多样,常见的例如:JS跳转、Flash跳转、302跳转等,而301跳转要单独来说,因为它是搜索引擎推荐和认可的跳转形式,它主要用在网站域名更改后将此域名指向彼域名,并且还可以将老域名的权重全部继承给新域名。除此之外的杂七杂八的跳转对搜索引擎来说都是不友好的,因为跳转本身就不利于蜘蛛的爬取,这也就是所谓的蜘蛛陷阱了。

普通情况下是不会做出这样的操作,一般灰帽或黑帽的朋友比较喜欢这种操作,采用变相引流的方法,让页面跳来跳去,但是实际上等于欺骗搜索引擎和用户。

六、动态URL

动态URL目前对于搜索引擎来说还是说可以识别的,但是如果大量的动态URL是不利于蜘蛛抓取的,时间长,也不利于优化。

搜索引擎比较喜欢静态网站,所以很多的动态网站都会使用伪静态设置。动态URL通俗的解释就是网站链接中带有各种参数、等号、问号或者其它符号而长度还很长的链接,对于那些有密集恐惧症的朋友来说这绝对是不能容忍的,恰巧的是蜘蛛也患有这种症状(哈哈哈),其实最根本的原因还是动态URL不利于蜘蛛的爬取。

七、登录限制

有登录限制的内容,对于搜索引擎来说它即不会注册也不会登录,这样的内容蜘蛛是发现不了的。

八、强制使用cookies

目前很少有网站采用这种限制了,为了想让用户记住网站、登录信息、跟踪访问路径等等情况,强制使用cookies等,造成的结果就是没有启用cookies的用户就访问不了,会提示页面无法正常显示,或者蜘蛛无法正常访问识别等情况。

九、很多弹出式聊天窗口

有些网站为了跟用户交流就时不时的强出很多聊天窗口,但是这些聊天窗口搜索引擎也是无法识别的。

标签: